Geçtiğimiz hafta Apple, çocukların güvenliğini sağlamak için geliştirdiği yeni özelliklerini tanıttı. Bunlar arasında yer alan Çocukların Cinsel İstismarı Nitelikli Materyalleri (CSAM) algılama teknolojisi küresel çapta adeta krize neden oldu. Açıklanan bilgiye göre sistem, çalışma mantığı gereği iCloud Fotoğraflar’da depolanan görselleri tarayacak ve pedofili ihtiva eden içerikler tespit ettiğinde bunu ABD’deki güvenlik güçlerine bildirecek.

CSAM algılama özelliğinin, Apple’ın iCloud Fotoğraflar’daki bütün görüntülere erişebileceği şeklinde yorumlanması üzerine şirket bir açıklama yaparak sistemin çalışma mantığını detaylandırmıştı. Kullanıcıların bütün verilerinin güvende olacağını taahhüt eden ABD’li firma bu kez de Alman hükümetinin radarına girdi. Dijital Gündem Komitesi başkanı Manuel Höferlin, Apple CEO’su Tim Cook özelinde uyarı yaptı.

Apple’dan çocuk istismarı açıklaması: Yanlış anlaşıldık

Son günlerde çocuk istismarını azaltmak için tanıttıkları özellik nedeni ile eleştirilen Apple, konu ile ilgili net bir açıklama yaptı.Hedefte Tim Cook! “CSAM algılamayı hayata geçirmeyin”

Heise Online sitesinin haberine göre, Almanya Federal Meclisi üyesi ve aynı zamanda Dijital Gündem Komitesi başkanı Manuel Höferlin, Apple CEO’su Tim Cook’a gönderdiği bir mektupta şirketin uygulamaya koymaya hazırlandığı CSAM tarama özelliğini “tehlikeli bir yol” olarak nitelendirdi.

Manuel Höferlin mektubun devamında CSAM taraması özelliğinin, “internetin icadından bu yana iletişim gizliliğine karşı yapılmış en büyük ihlal” olduğunu kaydetti. Güvenli ve gizli bir iletişim olmaksızın internetin “tarihteki en büyük gözetim aracı” olmaktan öteye gidemeyeceğini hatırlatan Höferlin, potansiyel sorunların önüne geçmek adına Apple’a çağrı yaparak yeni sistemi hayata geçirmemesini önerdi.

Apple’dan veya Tim Cook tarafından herhangi bir açıklama henüz gelmedi.

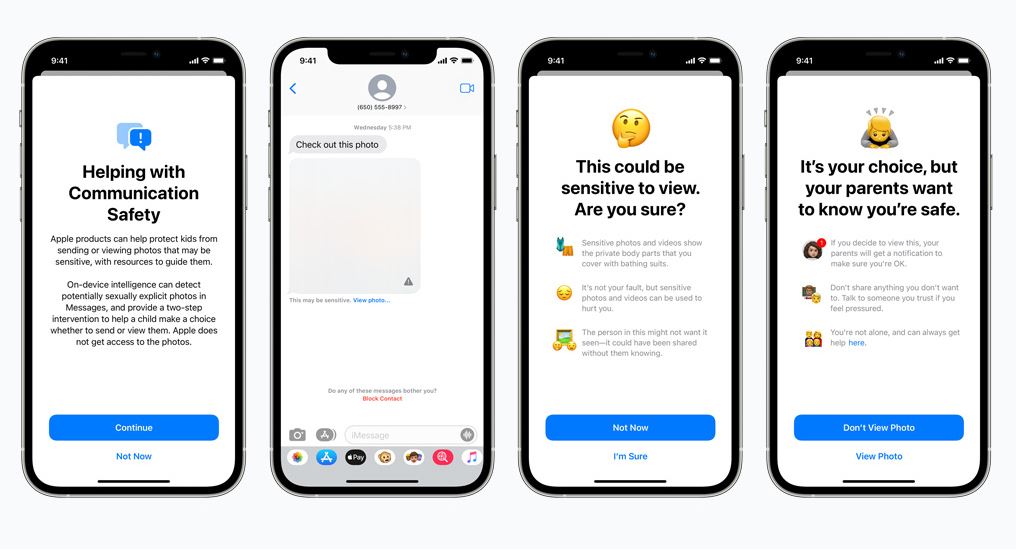

Yeni çocuk güvenliği özellikleri iOS 15 ile gelecek

Mesajlarda iletişim güvenliği ve çocuk istismarını otomatik algılamanın yanı sıra Siri filtrelemesi gibi yenilikler, bu yıl piyasaya sürülecek iOS 15, iPadOS 15, watchOS 8 ve macOS Monterey işletim sistemleriyle birlikte kullanıma sunulacak.

Bir iPhone kullanıcısının Mesajlar uygulamasıyla gönderdiği/aldığı fotoğraf otomatik olarak bulanıklaştırılacak ve çocuk uyarılacak. Korunmasına yardımcı olacak ek kaynaklar karşısına çıkarılacak ve dilerse fotoğrafı görmeme seçeneğine sahip olacak. Ayrıca müstehcen fotoğrafın açılması durumunda otomatik olarak ebeveynine haber verilecek ve çocuğa da uyarı yapılacak.

Çocuk istismarı içeren görüntülerin yayılmasıyla mücadele etmek amacıyla geliştirdiği yenilikten bahseden Apple, iOS ve iPadOS kullanıcılarının hizmetine bu yıl açılacağını belirtti. Söz konusu özellik, iCloud Fotoğraflar’da depolanan görüntüleri analiz edecek. Çocuk istismarı içeren bir görüntü tespit ettiğinde, ABD’deki kolluk kuvvetleriyle ortaklaşa hareket eden kâr amacı gütmeyen Ulusal Kayıp ve İstismara Uğramış Çocuklar Merkezi’ne (NCMEC) otomatik olarak bildirecek.

Bizde yöntem ne. Ayfon almaaa