Apple, güvenlik konusunda tüm cihazlarına en iyi korumayı vaat ediyor. Bugüne kadar iPhone’larıyla kullanıcılarına güven veren üretici, yeni yazılımlarıyla bunu daha da iyi bir hale getiriyor.

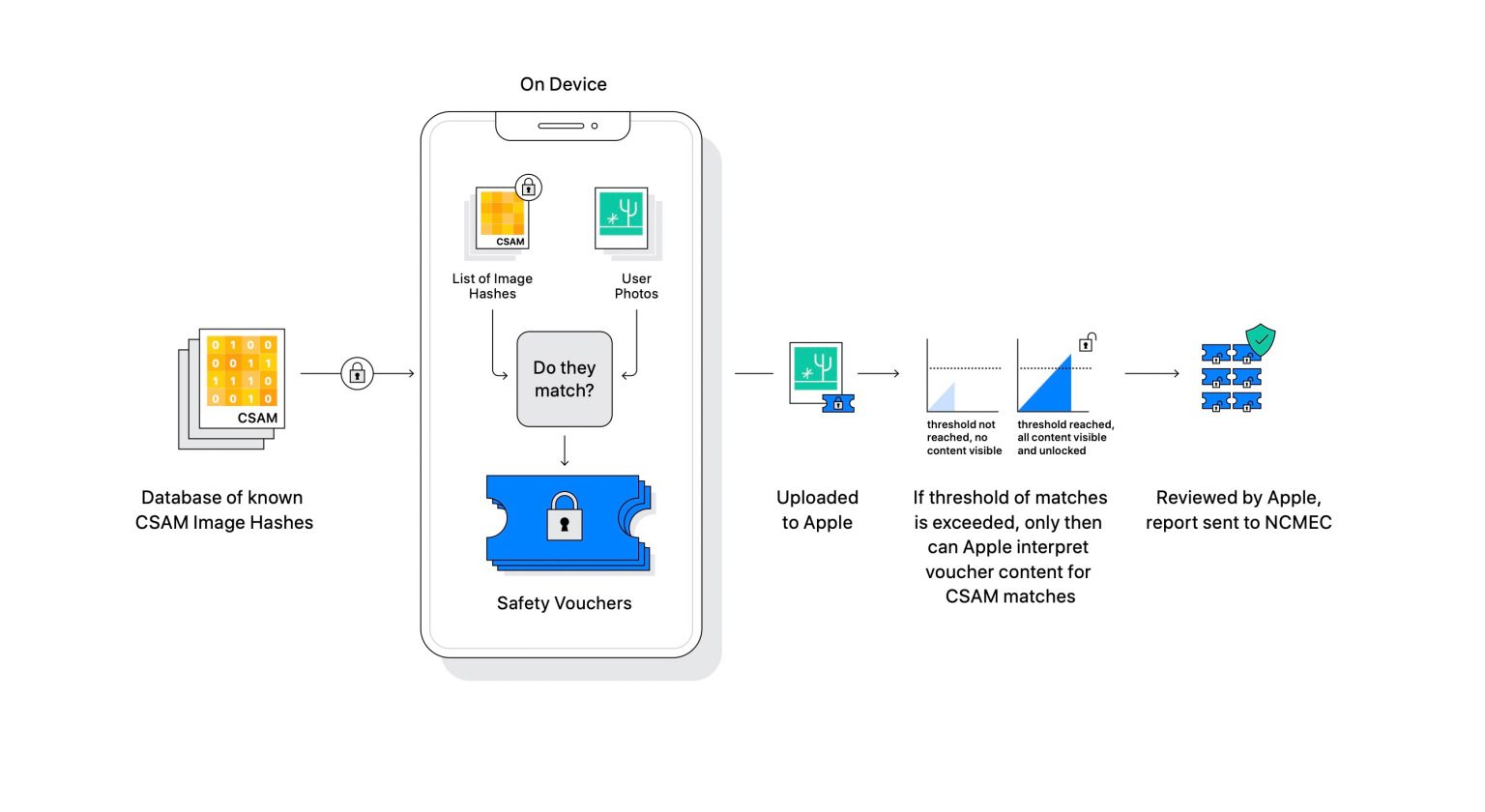

Bilindiği üzere Apple, kısa süre önce çocuk cinsel istismarlarına karşı yeni bir özelliğini duyurdu. CSAM ismi verilen bu özellik, iOS 15 ile beraber desteklenen tüm modellere sunulacak. Fakat kullanıcıların henüz bu yenilik hakkında kafalarında çok fazla soru işareti bulunuyordu. Neyse ki Apple kısa süre önce gerçekleştirdiği bir toplantı da tüm merakları giderdi.

Apple yeni otomobili için Güney Kore turunda!

Yayınlanan yeni bir rapor; Apple'ın gizli bir gezi ile "Apple Car" tedarik zincirine yeni ortaklar bulmaya çalıştığını söylüyor.Apple’ın yeni CSAM özelliği, yalnızca iCloud’daki fotoğraflarda çalışacak

Apple, bugün yeni CSAM algılaması hakkında kullanıcılara bazı bilgiler verdi. Bu bağlamda iOS 15 ile beraber sunulacak olan bu özellik, yalnızca iCloud Fotoğrafları’nda depolanan resimlerde geçerli olacak. Ancak firma ilerleyen zamanlarda bunun videolar içinde olabileceğinin sinyallerini verdi.

Öte yandan ABD’li üretici, CSAM özelliğinin nasıl devre dışı bırakıldığına da yine dikkat çekti. Bu bağlamda kullanıcılar yeni güvenlik özelliğini kullanmayı tercih etmez ise, iCloud Fotoğraflar’ı devre dışı bırakması yetecektir. Böylece uygulama arka planda çalışmaz ve herhangi bir verilerinize de erişmez.

Sunucu taraflı çalışan bu özellik, alıcıya gelen resimleri otomatik olarak tarayarak denetleyecek. Eğer burada çocuk istismarını tetikleyen bir görsel olduğunda o resim otomatik olarak bulanıklaştırılacak ve kullanıcıya uyarı olarak bildirilecek.

Apple’a göre CSAM algılama sistemi, diğer şirketler tarafından kullanılan sunucu taraflı uygulamalardan çok daha iyi. Şirket diğer uygulamaların her fotoğrafı taradığını öne sürerken, kendi algılama sistemlerinin ise sadece CSAM görüntüleri içeren fotoğraflarda çalışacağını ifade etti.