Google, Gemini yapay zeka aracının ürettiği “utanç verici ve yanlış” olarak tanımlanan görüntüler için bir açıklama yaptı. Cuma günü bir blog yazısında Google, modelinin ayar sorunları nedeniyle “yanlış tarihsel” görüntüler ürettiğini belirtiyor.

Gemini’nin ırkçı görüntüleri için Google açıklama yayınladı

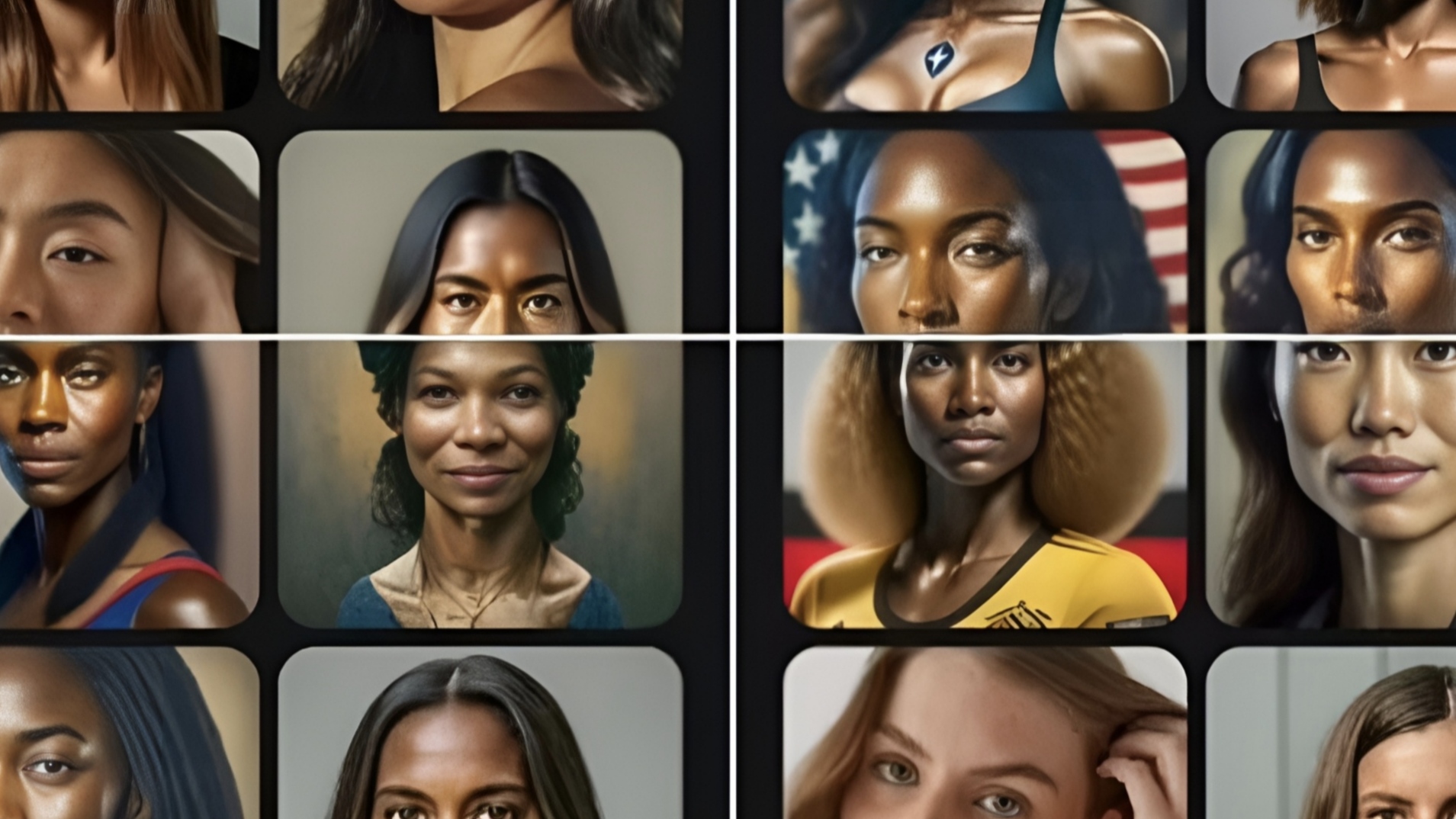

Bir çok kullanıcı, bu hafta başında Gemini’yi ırkçılıkla birlikte, çeşitli Nazi’ler ve ABD Kurucu Babaları’nı üretirken yakaladılar. Google’un kıdemli başkan yardımcısı Prabhakar Raghavan blog yazısında, “Gemini’nin çeşitli insanları göstermesini sağlamak için ayarlanmasının, kesinlikle çeşit göstermemesi gereken durumları hesaba katmadığını” açıkladı.

Ayrıca, “zamanla, modelin niyetimizden çok daha temkinli hale geldiğini ve bazı çok masum istekleri hassas olarak yanlış yorumladığını” belirtiyor. Bu, Gemini AI’ın bazı durumlarda “aşırı telafi etmesine” neden oldu, aynen ırkçı Nazi’lerin görüntülerinde gördüğümüz gibi.

Google, Gemini ile görsel oluşturmayı durdurdu! İşte nedeni

Google, Gemini yapay zeka ile insan görseli oluşturma servisini bir süreliğine durdurma kararı aldı. Peki ama bu karar neden alındı?Ayrıca, Gemini’nin “aşırı muhafazakar” hale gelmesine neden oldu. Bu, “siyahi bir kişi” veya “beyaz bir kişi” görüntülerinin belirli isteklerini üretmeyi reddettiğinde sonuçlandı. Raghavan blog yazısında, Google’ın “özelliğin iyi çalışmadığına üzgün olduğunu” belirtiyor.

Şirket, Gemini’nin “herkes için iyi çalışmasını” istediğini ve bu, “futbolcular” veya “bir köpeği gezdiren birini” görüntülerken farklı tipte insanların (farklı etnik kökenler de dahil olmak üzere) betimlemelerini elde etmek anlamına geldiğini belirtiyor.

Raghavan şöyle diyor: Ancak, “bir sınıftaki bir siyah öğretmen” veya “bir köpek ile bir beyaz veteriner” gibi belirli tipte insanlar veya belirli kültürel veya tarihsel bağlamlardaki insanlar için Gemini’ye görüntü istediğinizde, kesinlikle istediğiniz şeyi doğru bir şekilde yansıtan bir yanıt almalısınız.

Google Gemini’nin hizmeti yanlış görüntüleri yüzünden başlamadan bitti

Şirket, Gemini AI aracıyla insanların görüntülerini oluşturmasına 22 Şubat’ta son vermişti. Hem de bu karar, birkaç hafta öncesine kadar görüntü oluşturma özelliğini başlattıktan hemen sonra geldi.

Raghavan, şirketin görüntü oluşturma yeteneklerini test etmeye devam edeceğini ve yeniden etkinleştirmeden önce “önemli ölçüde iyileştirmeye çalışacağını” belirtiyor.

Raghavan, “Başlangıçtan beri söylediğimiz gibi, tüm LLM’lerle (büyük dil modelleri) halüsinasyonlar bilinen bir zorluk, yapay zeka bazen yanlış şeyler yapar. Bu, sürekli olarak üzerinde çalıştığımız bir şey.” açıklamasını yaptı.

Siz bu konu hakkında ne düşünüyorsunuz? Görüşlerinizi aşağıdaki yorumlar kısmına yazabilirsiniz.

Hepimiz aynıyız ırkçılık yapmayın

Senle aynı olacağıma zenci olurum